Depuis toujours, toutes les époques, toutes les cultures et toutes les religions partagent l’intuition d’une fin du monde brutale et violente.

Au fil de l’histoire, de la philosophie, de la science, de la psychologie, l’art – et plus récemment la technologie – semble avoir permis de repousser cette échéance. Mais le sentiment d’un dénouement inévitable demeure. L’humanité croit avoir gagné du temps, sans jamais dissiper l’ombre de sa propre fin.

Loin des prophéties mystiques à la Nostradamus, souvent trop sujettes à l’interprétation, certains modèles modernes issus des mathématiques, de la physique et de la finance, annoncent, eux aussi, un basculement total, après lequel la place que nous occuperons demeure bien floue.

Nous ne parlons pas d’une prédiction facile qui cible les prochains millénaires, mais d’un choc à l’horizon 2050. Autant dire après-demain.

Avant de détailler les fondements de ces modèles, rappelons que la date en elle-même importe peu. Ce qui compte, c’est la méthodologie proposée, la cohérence des signaux évoqués, et la portée symbolique de cette convergence entre science, finance et destin.

Une convergence qui doit nous interpeller, en tant qu’investisseur, sur un risque structurel latent dans le secteur technologique. Un risque difficile à concevoir aujourd’hui, dans l’euphorie ambiante, mais qui participe peut-être à quelque chose de plus grand que tout ce qu’on a pu connaître jusque-là.

👉 Pour comprendre les dynamiques à l’œuvre dans le secteur technologique, et saisir les opportunités dès maintenant tout en identifiant les risques réels, c’est par ici.

Au sommaire :

1. Une brève histoire humaine

2. Log-périodicité : à l’origine des cycles technologiques, les cycles du vivant

3. L’économie de la cognition, la nouvelle phase post-singularité

4. Quand l’information supplante le travail productif

5. L’économie de l’information appelle une énergie gratuite

6. Alea jacta est, vraiment ?

Une brève histoire humaine

Dans une précédente publication, nous avions rappelé que la technologie, dès l’instant où elle émerge dans nos sociétés, tend à se propager sans jamais décélérer.

Avec une lecture optimiste, on pourrait imaginer ce nouveau monde proche de celui de Star Wars où les avancées technologiques, biologiques et sociales s’entrecroisent, se complètent même, sans chercher à s’anéantir mutuellement ni à éliminer les modèles – vivants ou artificiels – qui coexistent.

Seulement, dans notre monde réel bien à nous, l’optimisme l’emporte difficilement sur le pessimisme. Un pessimisme que l’on a pu découvrir chez Günther Anders, qui s’interrogeait sur le monde d’après déjà en 1956, à une époque très peu pourvue de technologies disruptives. Mais aussi chez des auteurs plus contemporains, comme Vernor Vinge qui a publié un essai sur la singularité technologique en 1993, et Raymond Kurzweil, ingénieur et écrivain, qui travaille activement chez Google depuis 2012 sur l’apprentissage automatisé, qui développera le même sujet en 2005 avec son ouvrage The Singularity is near.

Le concept de singularité, tel qu’ils le décrivent, marque ce moment redouté où la courbe du progrès dépasse celle de notre adaptation. L’humanité, submergée par ses propres créations, perd alors les leviers qui lui permettaient jusque-là de comprendre et de maîtriser le monde.

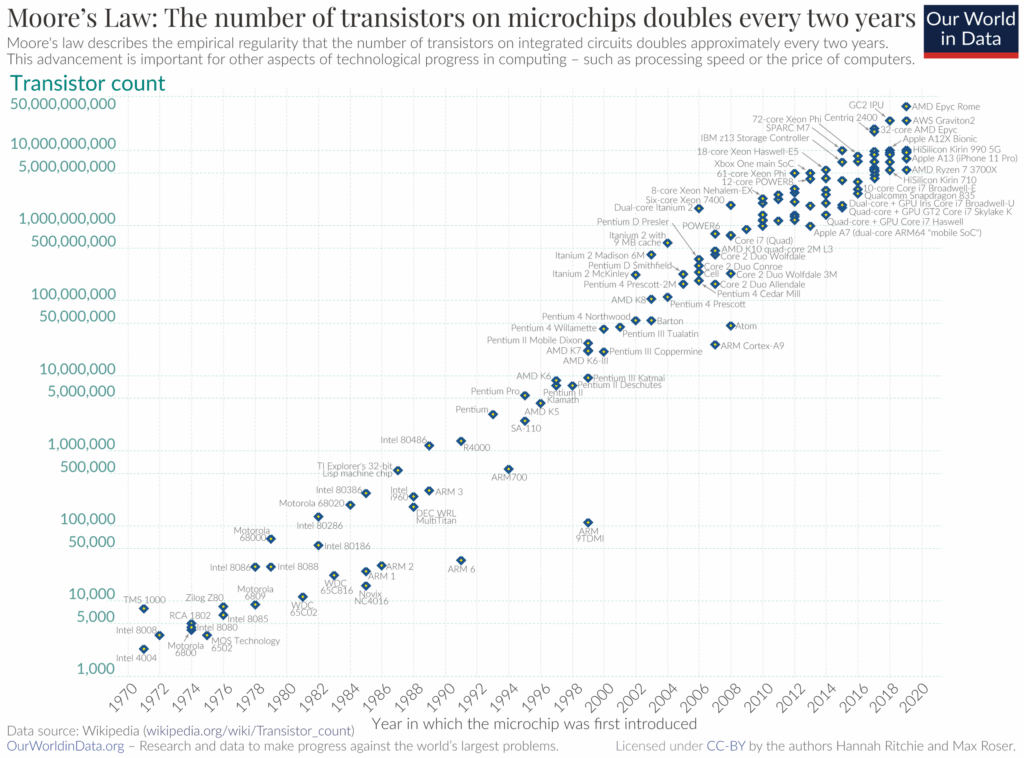

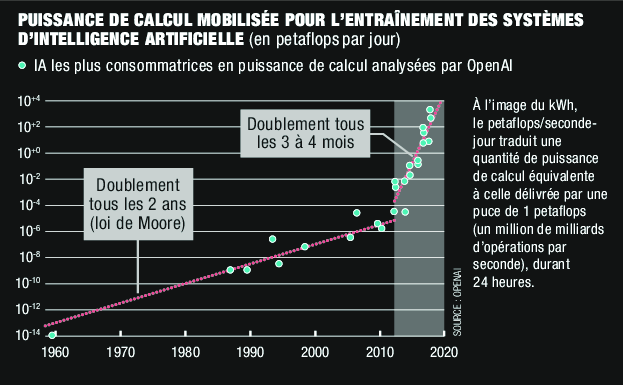

Un point de non-retour souvent rapproché des projections autour de la loi de Moore, selon laquelle la puissance de calcul informatique, dépendante du nombre de transistors, double tous les 18-24 mois. Cette loi alimente une vision accélérationniste et exponentielle du progrès technologique, où chaque avancée nourrit la suivante. Un point de bascule qui, désormais, semble se rapprocher à grands pas.

Notons que plus on ajoute de composants pour accroître la puissance de calcul, plus cette puissance renforce notre capacité à produire de nouveaux composants. Une spirale auto-entretenue que rien ne semble pouvoir ralentir.

Loi de Moore : le nombre de transistors sur les microprocesseurs double tous les deux ans

Source : Wikipedia / Wikimedia Foundation ; données issues de Wikipedia compilées par Our World in Data.

Graphique créé par Our World in Data. Auteur : Hannah Ritchie et Max Roser.

La loi de Moore décrit la régularité empirique selon laquelle le nombre de transistors sur les circuits intégrés double approximativement tous les deux ans, ce qui entraîne des progrès technologiques rapides dans le calcul et une augmentation de la puissance par unité de coût.

Si l’on observe la puissance de calcul mobilisée pour l’intelligence artificielle, on constate que la loi de Moore a été dépassée : la progression est désormais sur-exponentielle, autrement dit bien plus rapide que prévu.

Lorsqu’on parle de singularité, et non simplement d’entrée dans un nouveau monde, on fait implicitement référence à la singularité gravitationnelle d’un trou noir : ce point au-delà duquel les lois connues cessent de s’appliquer, où plus rien de ce que nous connaissons ne fonctionne, où tout est néant.

Faut-il y voir la fin du monde, ou seulement la fin d’un modèle ? Est-ce l’effondrement de nos certitudes ou bien un choc transcendantal, reléguant notre science moderne au rang de simple bidouillage ?

Dans son ouvrage, Raymond Kurzweil situe cette singularité précisément aux alentours de 2045-2050.

“Vers 2045, un ordinateur à 1 000 $ aura la puissance de calcul d’un cerveau humain, et l’ensemble de la puissance informatique mondiale dépassera celle de tous les cerveaux humains combinés.”

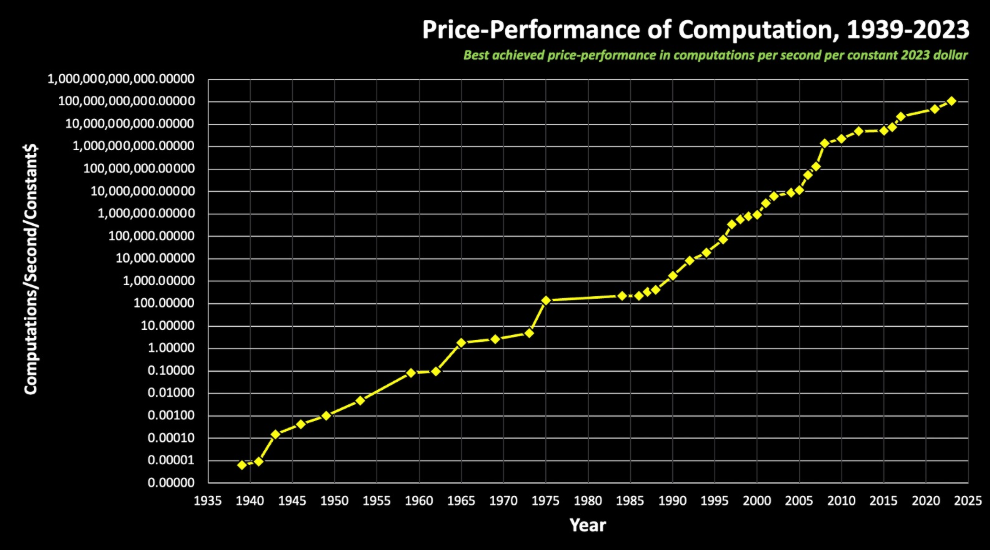

Rapport performance/prix du calcul (1939-2023)

Ce graphique nous montre la meilleure puissance de calcul par seconde et par dollar constant de 2023. C’est sans appel.

Pour ceux qui se demandent comment comparer la puissance d’un cerveau face à celle de l’IA : avec 20 Watts de puissance, le cerveau humain délivre 10¹⁷ FLOPS, qui mesurent le nombre d’opérations par seconde, tandis que l’intelligence artificielle et les supercalculateurs sont déjà à 10¹⁹ FLOPS en 2025.

Pour l’investisseur attentif aux opportunités comme aux risques, l’enjeu est donc de comprendre si la dynamique actuelle nous conduit vers une simple mutation du système… ou vers sa fin annoncée, sans toutefois en connaître la nature.

Sommes-nous sur le point d’interrompre l’histoire encore balbutiante d’Homo Sapiens, une brève histoire de l’humanité qui compte trois cent mille ans d’existence à peine, face aux milliards d’années qu’il a fallu pour façonner notre planète ?

Log-périodicité : à l’origine des cycles technologiques, les cycles du vivant

Pour mieux comprendre, prenons un peu de recul.

Avant de parler des cycles d’évolution technologique, il faut évoquer les cycles de développement biologique, et prendre une photographie du vivant à date, et depuis les origines de la Terre.

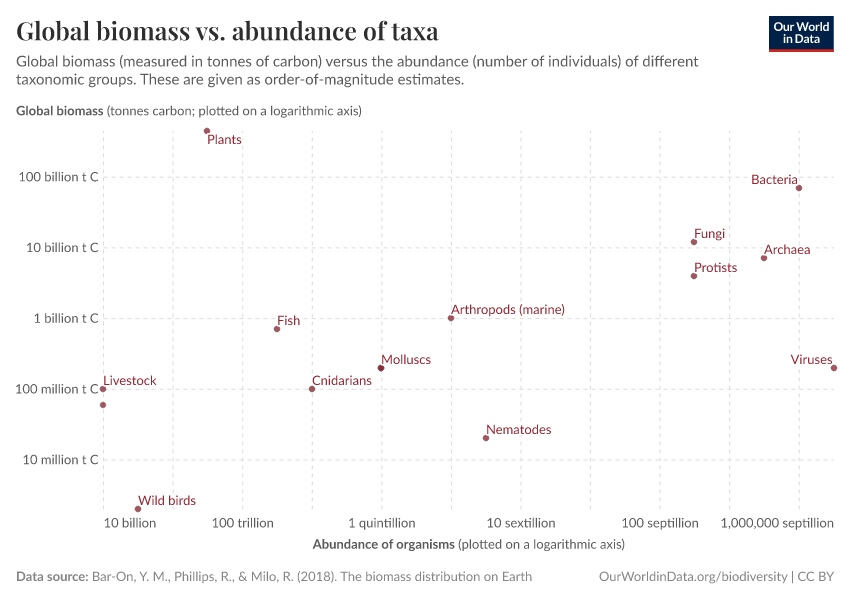

Le schéma ci-dessous illustre la répartition des principales formes de vie connues selon deux axes logarithmiques : la biomasse totale (en ordonnée) et l’abondance de cette espèce, c’est-à-dire le nombre d’individus ou la densité de population (en abscisse).

Biomasse mondiale vs abondance d’un groupe d’êtres vivants

Il nous révèle que plus un organisme est complexe, cognitivement développé ou énergétiquement exigeant, plus il devient rare et sa biomasse relative diminue.

La complexification biologique s’accompagne presque toujours d’une rareté statistique et d’une densité énergétique. La Nature semble “redistribuer” l’énergie disponible – non plus pour multiplier les individus, mais pour approfondir leur capacité de traitement de l’information.

Ainsi, Homo sapiens n’est ni le plus massif ni le plus nombreux, mais il incarne, à ce jour, le maximum de complexité par unité de matière et d’énergie.

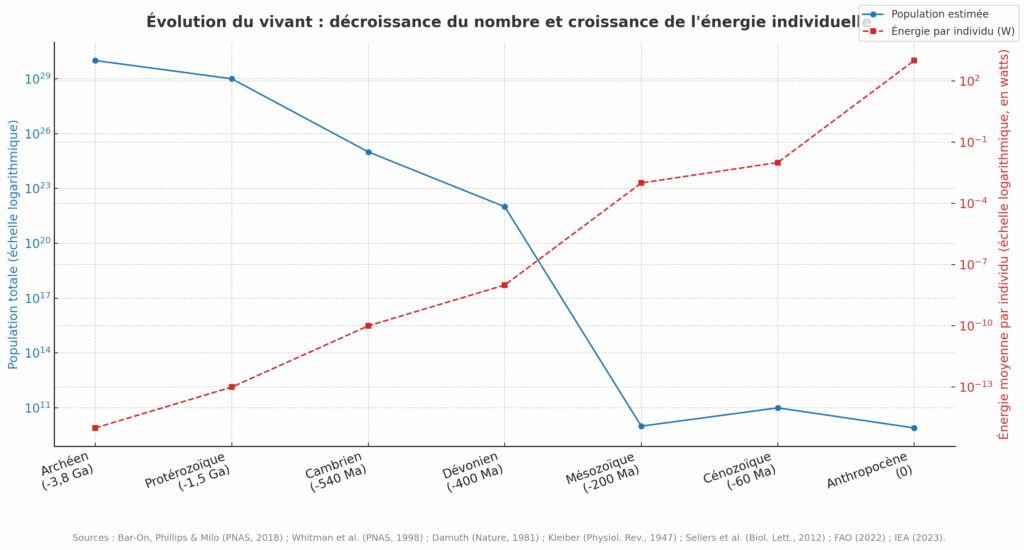

Ce graphique compare justement l’énergie moyenne libérée par individu et la population des espèces. Nous nous situons tout à gauche, dans l’Anthropocène (ère de l’être humain).

Nous ne pouvons évidemment pas comparer des choux et des carottes. Placer l’intelligence artificielle sur cette courbe reviendrait à confondre le vivant biologique et le vivant technologique, et souffrirait donc d’un certain manque de rigueur méthodologique.

Mais pour celles et ceux qui soutiennent que cette technologie est si disruptive qu’elle pourrait annoncer l’émergence d’une nouvelle espèce, alors l’hypothèse mérite d’être posée.

Si l’on admet, ne serait-ce qu’en pensée, que l’IA parvienne un jour à s’émanciper énergétiquement de sa dépendance à l’humain – c’est-à-dire à produire et entretenir seule le flux d’énergie nécessaire à son existence, car c’est son principal défaut aujourd’hui – alors oui, il s’agirait bel et bien d’une nouvelle espèce, venant prolonger la trajectoire de la fameuse courbe bleue : celle d’une cognition toujours plus concentrée, et d’un nombre d’individus toujours plus restreint.

Chacune de ces espèces a connu des temps de domination de plus en plus courts. Et chacune de ces fins de règne s’est accompagnée de la percée rapide d’une nouvelle espèce, reprenant le rôle de leader.

Nos trois cent mille ans d’existence paraissent bien dérisoires face aux millions d’années d’évolution des dinosaures, eux-mêmes éphémères comparés à la longue maturation biologique des mollusques ou des bactéries, pionniers de la grande Histoire de la vie.

En économie comme en finance, on observe également cette tendance à l’accélération des cycles, dont la durée ne cesse de se raccourcir. Didier Sornette, économiste, physicien et chercheur franco-suisse, connu pour avoir appliqué les méthodes de la physique à la finance et à l’économie, a formalisé ce phénomène sous le nom de log-périodicité.

Selon lui, chaque bulle spéculative est avant tout l’expression d’une agitation croissante précédant une transition de phase – comparable à ce qui se produit en physique à la veille d’un changement d’état.

Comme pour l’eau qui bout, les premiers signes sont discrets, puis s’intensifient jusqu’à la rupture.

Quand on fait monter en température de l’eau, rien ne semble se passer pendant les quatre ou cinq premières minutes. Puis, soudain, apparaissent de petits frémissements, suivis de bulles plus larges, jusqu’à ce que l’ébullition totale survienne vers la neuvième ou dixième minute.

Avant qu’Homo Sapiens n’émerge, ces transitions de phase de type log-périodique avaient déjà été observées.

Les dinosaures n’ont pas disparu uniquement à cause de l’astéroïde tombé dans la région du Yucatán au Mexique. Les études menées au cours des trente dernières années ont croisé des données, révélant un contexte planétaire déjà fragilisé avant l’impact.

Une intense activité volcanique avait détérioré la qualité de l’air et bouleversé les écosystèmes. Un réchauffement progressif s’était alors installé, affaiblissant peu à peu le règne des dinosaures – notamment les espèces herbivores – tandis que la biodiversité s’appauvrissait. L’impact de la météorite et l’obscurité totale qui en résulta ne firent qu’achever brutalement une ère déjà sur le déclin.

On peut interpréter la fin du règne des dinosaures comme une transition de phase log-périodique, qui a laissé place à de nouvelles phases.

L’évolution du vivant est une forme de bulle qui se termine par un éclatement violent. Et Homo sapiens n’est peut-être que la dernière oscillation avant une possible singularité. Une singularité sans doute d’un genre inédit, qui pourrait s’incarner dans l’intelligence artificielle.

En attendant la suite, prenez place du bon côté de l’histoire.

👉 Découvrez ces entreprises américaines qui préparent le monde de demain.

L’économie de la cognition, la nouvelle phase post-singularité

Maintenant que l’on comprend mieux le lien entre la log-périodicité et la théorie de la singularité, il faut examiner les données des XXᵉ et XXIᵉ siècles pour vérifier si la disruption technologique traduit bien une accélération annonciatrice de la fin d’un modèle. Une fin qui, rappelons-le, serait attendue autour de 2050, selon certaines estimations.

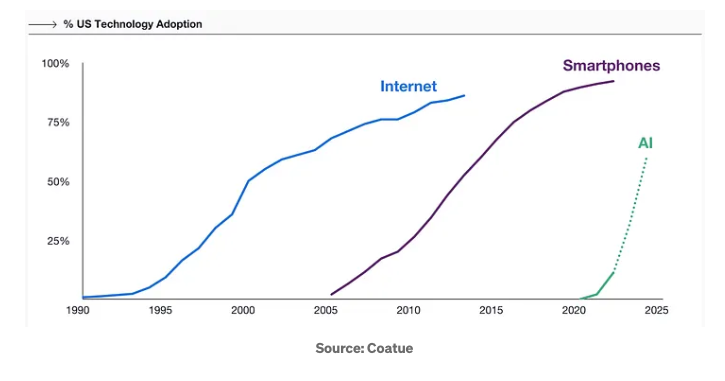

Commençons par une évidence qui mérite d’être rappelée, et qui s’inscrit bien dans la phase d’accélération décrite par Didier Sornette : les cycles d’innovation sont de plus en plus courts ; ils émergent plus vite ; ils croissent plus vite.

L’intelligence artificielle ne déroge pas à la règle : son adoption progresse encore plus vite que celle des cryptomonnaies, lesquelles avaient déjà légèrement surpassé le rythme d’adoption d’Internet.

Pour soutenir ce rythme, nous avons assisté à un double phénomène : une augmentation de la productivité, et une augmentation de la concentration du capital.

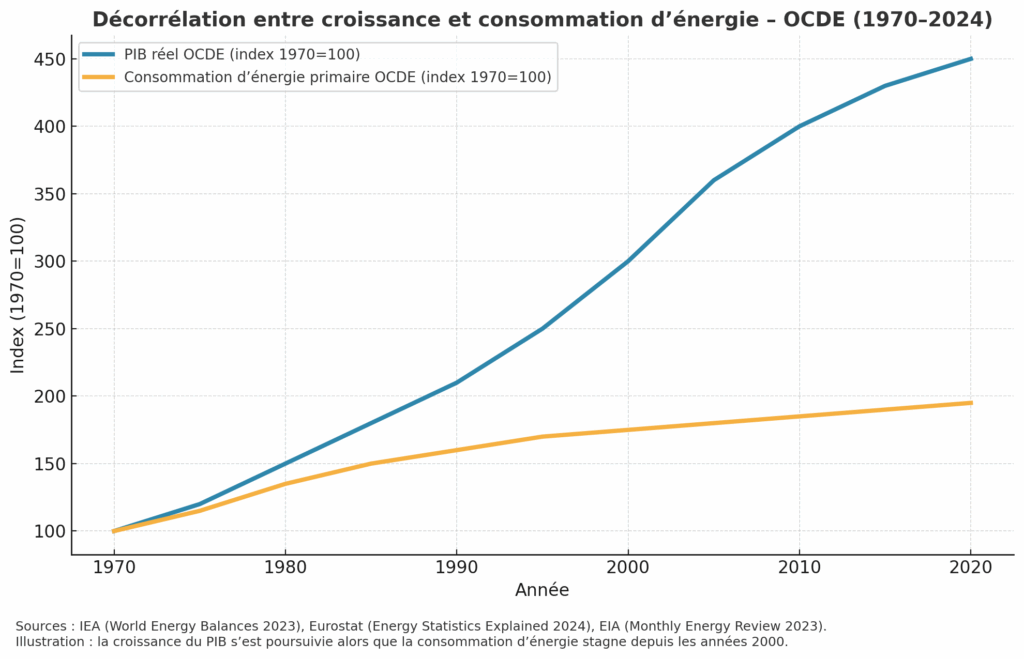

Entre 1950 et 2020, la productivité horaire dans les pays de l’OCDE a été multipliée par six, alors que l’énergie consommée par habitant est restée quasiment stable. Ce qui fait écho avec les développements de la première partie.

Avec beaucoup moins, on fait toujours plus, au sens de la dissipation énergétique.

Cette hausse de la productivité a eu un effet récursif : elle s’est nourrie d’elle-même. Les pays de l’OCDE, principaux détenteurs de capitaux et d’innovations, ont massivement investi dans le tertiaire et les nouvelles technologies. Ces investissements ont alimenté la R&D, ce qui a donc amplifié les gains de productivité, ravivant l’intérêt des investisseurs pour ces mêmes technologies à cause des résultats productifs constatés, et enclenchant donc une véritable boucle auto-entretenue. Et tout cela participant aussi à diminuer considérablement les besoins en énergie, et à délivrer des outils et des technologies moins consommatrices.

Nous passons dans l’ère “avec vraiment peu, on commence à faire vraiment énormément”.

Cette dynamique se vérifie par la décorrélation croissante entre la dépense énergétique et la croissance du PIB. Ce lien s’est distendu à mesure que les machines et l’automatisation ont pris une place centrale dans nos vies.

De 1990 à 2022, le PIB des pays de l’OCDE a augmenté de +75%, tandis que leur consommation d’énergie primaire est restée globalement stable avec un maigre +4% (données IEA 2023). En Europe, sur la même période, c’est une croissance du PIB de +66% qui est à mettre en face d’une baisse de la consommation énergétique de 4% (données Eurostat 2024).

Et aux USA, pays de la technologie, le PIB réel a quant à lui progressé de 30 % depuis 2007, tandis que la consommation d’énergie a légèrement diminué (IEA 2023).

Cette rupture marque l’émergence d’une forme d’intelligence productive substitutive : celle d’un progrès capable de croître et de s’auto-alimenter sans consommer toujours plus d’énergie.

Pour ce que nous en savons, cette intelligence substitutive n’est pas survenue sans raison.

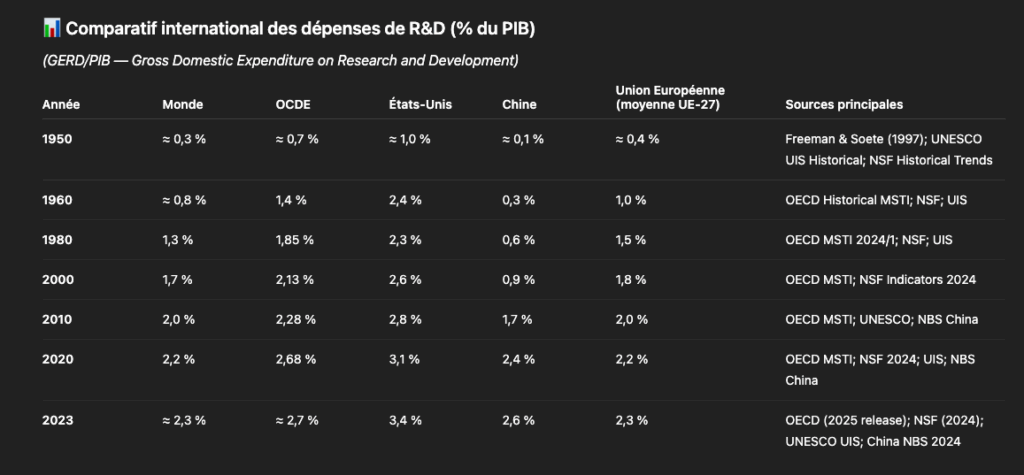

Avec des dépenses mondiales de R&D passées d’environ 0,3 % du PIB dans les années 1950 à 2,3 % en 2023, le volume de capitaux consacrés aux technologies est passé d’une poignée de milliards de dollars à plusieurs milliers de milliards, illustrant la montée en puissance continue de l’économie de la connaissance en tant que substitut au travail productif classique.

On notera que la Chine a connu une ascension fulgurante, que nous avons d’ailleurs évoquée dans une interview à paraître la semaine prochaine avec Jacques Lemoisson (Gate Capital Management).

Ce qu’on constate, c’est que sur longue période, le capital se détourne progressivement d’innombrables secteurs et abonde dans la cognition numérique : cloud, data centers, intelligence artificielle, robotique…

Nous en parlons régulièrement avec Jean-Michel Salvador dans nos émissions. Il y partage sa vision du marché, ses perspectives et les potentiels d’appréciation de ses principales convictions.

👉 Retrouvez dès maintenant ses analyses en vous inscrivant aux Top Picks U.S.

En 2025, les “Magnificent 7” (Apple, Microsoft, Google, Meta, Amazon, Nvidia, Tesla) pèsent près de 45% du Nasdaq-100. Une part importante, et toujours grandissante, de leurs activités, repose sur l’accumulation de données et de puissance computationnelle, et non de biens matériels comme d’autres entreprises plus traditionnelles.

Raymond Kurzweil, évoqué précédemment et fervent défenseur de l’hypothèse d’une singularité technologique et civilisationnelle, y voit le symptôme d’un basculement économique vers une économie de la cognition.

Concentration des capitaux, polarisation sectorielle, uniformisation des technologies, accélération du rythme des innovations et prolifération de “nouvelles” technologies donnent le sentiment d’avoir affaire à une accélération de phase, comme l’évoquait Didier Sornette avec son log-périodicité, où les cycles se contractent à mesure qu’on s’approche du point de rupture.

En mobilisant les séries longues du Dow Jones depuis 1896 et de l’indice S&P 500 depuis 1957, Raymond Kurzweil observe que la croissance des marchés américains est en moyenne d’environ 6,5–7 % par an en termes réels, mais que cette progression n’est pas linéaire : elle se fait par grandes phases économiques distinctes, ponctuées de sauts brutaux, souvent associés aux grandes vagues d’innovation et de réallocation du capital décrites par Perez et par la littérature sur les General Purpose Technologies.

Ce sont des chocs productifs ou des chocs technologiques qui alimentent les croissances exponentielles, rien de moins.

L’autre élément à noter, en cohérence avec la logique de log-périodicité, est l’élasticité des rebonds de marché. Sur la base de données compilées, émanant de JPMorgan, Betashares, MorningStar et Neuberger Berman, les chutes de marché apparaissent plus rapides, et les rebonds plus violents. Une parfaite signature log-périodique d’un système global en tension critique.

De 1900 à 1980, on comptabilise environ 15 krachs financiers. Soit un krach en moyenne tous les 5 ans, chacun marqué par une chute d’au moins 20 %.

De 1980 à 2025 – sachant que l’année n’est pas terminée – on a pratiquement le même nombre. Entre 14 et 15, selon les analystes.

Autrement dit, un krach majeur survient désormais tous les trois ans en moyenne.

Les phases de reprise suivent la même logique d’accélération que les krachs eux-mêmes. Mais elles se distinguent par une élasticité spectaculaire. Les chocs violents ont souvent ouvert la voie à des hausses historiques. Dans un cas sur deux, les nouveaux sommets sont atteints en moins d’un an après le krach.

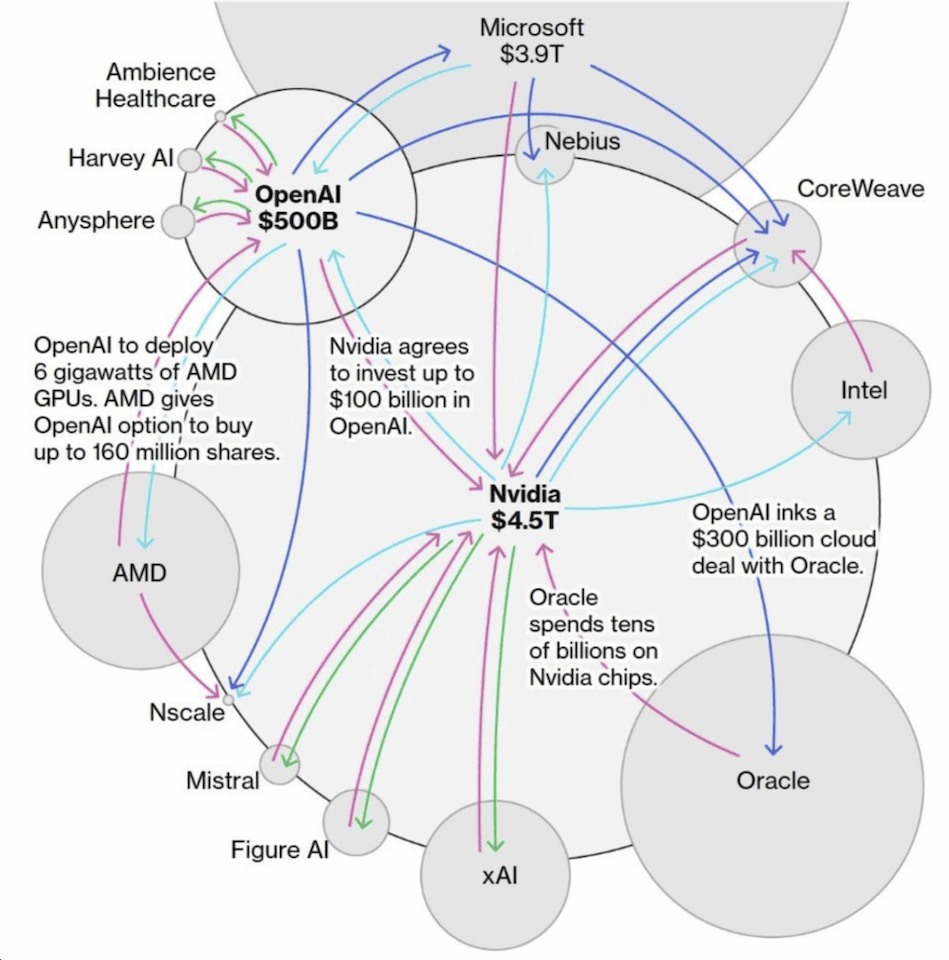

Et comme en 2000, les investissements s’emballent.

À chaque trimestre, les besoins explosent.

Et selon Sam Altman (OpenAI), il faudra des milliers de milliards de dollars d’ici 2030 pour viabiliser le nouvel écosystème de l’IA.

Une agitation extrême, caractéristique d’une phase log-périodique, que l’on ne retrouve pas dans d’autres secteurs. Par exemple, dans l’énergie, les investissements déclinent de 3% par an environ, selon Rocky Mountain Institute, comparé à des projections jusqu’à +30% d’investissements pour l’IA. Le delta est colossal.

Quand l’information supplante le travail productif

La vision ricardienne de l’économie privilégie la valorisation des acquis technologiques plutôt que leur remise en cause, contrairement au modèle schumpétérien fondé sur la destruction créatrice.

On cherche avant tout à rentabiliser à l’extrême ce qui fonctionne déjà, en produisant en masse, sans nécessairement intensifier les investissements.

C’est ce modèle qui a permis à la Chine d’ériger des infrastructures en un temps record.

Ce modèle ricardien se vérifie dans de nombreux secteurs conventionnels. Prenons un exemple concret : une fois qu’on sait construire un immeuble, on commence par en bâtir, avant de se demander s’il n’aurait pas mieux valu réfléchir à une autre approche de la construction.

Mais ce raisonnement ricardien ne fonctionne plus dans une économie essentiellement tertiaire, encore moins dans la technologie. Car, je cite, “quand la ressource principale devient l’intelligence informationnelle, les rendements deviennent croissants.”

De la croissance à l’hypercroissance

Raymond Kurzweil estime que les technologies de l’information sont des vecteurs de valeur pour deux raisons : elles encapsulent une connaissance dans un savoir-faire, et elles peuvent déclencher des interactions inédites.

Typiquement, Internet est un réseau sans valeur qui a permis à tout un chacun d’en créer. Aujourd’hui, la situation s’est inversée : Internet possède une valeur intrinsèque, indépendamment de ce que nous produisons dessus. Le réseau lui-même est devenu une source autonome de richesse.

Et avec les cryptomonnaies, c’est encore plus vrai car le réseau Bitcoin, par exemple, ne se contente pas de transporter de l’information, il transporte nativement de la valeur économique.

Les rendements associés aux technologies de cet ordre ont donc tendance à progresser à mesure que l’effet de réseau s’installe, rompant avec les modèles traditionnels, tels que celui de la construction évoqué précédemment.

Donc, tant que la “matière informationnelle” (IA, cloud, data, etc…) croît exponentiellement en termes de capacités, comme le suggère la loi de Moore, les marchés tiennent car les rendements devraient rester mécaniquement croissants.

Conceptuellement, cela reviendrait à dire que plus on produit de GPUs, plus on concentre les capitaux, plus on les réinjecte dans les GPUs, et ainsi de suite.

L’économie de la connaissance, soutenue par des data centers, GPUs et autres matériels techniques, n’épuise pas la ressource : elle la multiplie.

L’économie de l’information appelle une énergie gratuite

Si l’on poursuit la logique évoquée plus haut – celle de la miniaturisation des foyers d’intelligence et de la dissipation énergétique -, il devient clair que pour atteindre une telle densité énergétique, deux voies principales s’imposent :

soit innover davantage dans la production d’énergie ;

soit faire chuter drastiquement son coût, tout en améliorant l’efficacité de la consommation. C’est ce levier-là qui conditionnera essentiellement le développement des prochaines générations technologiques, dont la production énergétique elle-même.

Et la bonne nouvelle, c’est que cette double dynamique est déjà à l’œuvre.

La fusion nucléaire progresse rapidement

En Chine, le tokamak EAST a maintenu un plasma en bon confinement pendant 1 066 secondes (soit 17 min 46 s) en janvier 2025. En France, le tokamak WEST, a battu ce record le 12 février 2025, en maintenant un plasma d’hydrogène pendant 1 337 secondes (soit 22 min 17 s), avec environ 2,6 GJ d’énergie injectée et extraite (Phys.org, IAEA-Fusion Portal).

Ces avancées confirment que la fusion contrôlée devient progressivement une réalité technique, même si les expériences actuelles, aussi prometteuses soient-elles, ne produisent pas encore de bilan énergétique net positif.

L’industrialisation reste donc prématurée, mais la trajectoire scientifique est désormais solidement établie.

La baisse des coûts énergétiques, moteur d’innovation

Du côté des énergies renouvelables, les tendances de long terme confirment une baisse structurelle des coûts : selon l’IRENA (Renewable Power Generation Costs 2024), le coût actualisé du kWh solaire a chuté de 87 % depuis 2010, celui de l’éolien terrestre de 63 %, et celui de l’éolien en mer de 56 %.

Cette baisse, combinée à une meilleure efficacité, contribue à réduire la pression énergétique globale et à libérer des ressources pour d’autres innovations technologiques.

Rendement et transition

En 2024, les énergies renouvelables ne représentent encore qu’environ 13–15 % de l’énergie primaire mondiale mais elles fournissent déjà près de 32 % de la production mondiale d’électricité (Ember – Global Electricity Review 2025).

Cet écart apparent provient d’un effet mécanique de rendement : les filières solaire, éolienne et hydraulique convertissent directement l’énergie naturelle en électricité, sans les pertes thermiques des centrales à gaz, à charbon ou nucléaires.

Ainsi, à quantité d’énergie primaire équivalente, elles génèrent davantage d’électricité utile, signe tangible d’une efficacité énergétique croissante et d’une transition technologique accélérée.

Lors du forum du World Economic Forum Annual Meeting 2024 à Davos, Sam Altman avait justement déclaré que « l’avenir de l’IA dépend d’une percée énergétique ».

Si les coûts énergétiques poursuivent leur baisse et que, parallèlement, la fusion nucléaire atteint sa maturité, on peut raisonnablement envisager une trajectoire tendant vers un coût marginal proche de zéro. Comme pour la puissance de calcul qu’on a citée plus haut.

Alea jacta est, vraiment ?

Alors que retenir de toutes ces théories ?

Faisons un petit tour dans l’espace.

Dans les années 70, Carl Sagan a élaboré un message codé destiné à d’éventuelles civilisations extraterrestres, censé représenter ce que nous sommes en tant qu’espèce.

Or à l’échelle du vivant, Homo sapiens est une poussière : noyé dans l’immensité du monde marin, où fourmillent des milliards de milliards d’organismes. Sous cet angle, le plancton serait le véritable souverain de la planète. Mais si l’on ne regarde plus la masse, et qu’on observe la dissipation d’énergie, c’est-à-dire la puissance déployée par chaque forme de vie, la hiérarchie s’inverse : l’homme devient colossal par l’énergie qu’il libère.

Et sur ce terrain, l’intelligence artificielle semble déjà engagée sur la même trajectoire, prête, peut-être, à nous dépasser.

Nous n’y sommes pas encore.

Mais bientôt.

Peut-être en 2050. Qui sait.

Revenons à présent sur Terre.

Il y a d’autres éléments donnés intéressants à prendre en compte, qui viennent conforter l’intuition de Günther Anders (de nouveau).

« L’homme contemporain ne s’appartient plus jusque dans son intimité : ses gestes, ses désirs, ses plaisirs, ses amours sont devenus des fonctions. »

Les réseaux sociaux et les applications de rencontre en sont l’illustration : les émotions se quantifient, se trient, se notent.

Aux États-Unis, 37 % des adultes déclarent avoir eu recours à une application de rencontre, même si près de 80 % d’entre eux disent ressentir une forme d’épuisement à l’utilisation. Même la Gen Z, pourtant au cœur du phénomène, juge ces interactions trop superficielles. Mais ce sont pourtant 360 millions de personnes qui continuent d’y chercher un partenaire.

Les affects deviennent quantifiables, triables et calculables. On standardise la qualité des rapports humains, leur type, leur durée et la satisfaction qu’on est en droit d’attendre.

Si l’intime, pourtant très humain par nature, commence à nous échapper, il n’est pas le seul. Dans les pays européens, les technologies de reproduction assistée (ART) ont permis à près de 9% des naissances d’aboutir. Mais malgré cela, le taux de fécondité moyen continue sa lente érosion.

Peu à peu une ère post-humaine semble se dessiner.

Mais ces systèmes avancent souvent à tâtons, empilant hypothèses et paris technologiques. D’où la nécessité, pour l’investisseur, de suivre de près l’évolution du secteur technologique, sans se laisser griser par ses promesses.

C’est ce que nous faisons chaque mois avec Jean-Michel Salvador dans les Top Picks U.S. (les meilleures recommandations du moment).

👉 Rejoignez-nous ici dès maintenant pour découvrir ses recommandations et ne pas passer à côté des dernières informations sur les valeurs technologiques américaines.

Parmi les hypothèses les plus courantes, nous retrouvons les projections autour de la loi de Moore. Aussi séduisante soit-elle, elle a connu plusieurs ralentissements majeurs et ne saurait donc être considérée comme une loi universelle.

Dès 2012, la miniaturisation des transistors a buté sur des limites physiques et économiques : la poursuite du doublement de puissance n’était plus rentable. Ce sont alors les politiques publiques et les subventions massives – américaines, taïwanaises, coréennes et chinoises – qui ont relancé la machine productive, notamment via les plans CHIPS Act et Made in China 2025 (datant de 2015).

Là où l’on pouvait penser que la technologie s’auto-alimentait mécaniquement, c’est bien l’intervention humaine – économique et politique – qui a permis de prolonger son cycle, et non une quelconque dynamique autonome comme le pensait Günther Anders, philosophe et auteur de “L’Obsolescence de l’homme”.

Sur le plan physique cette fois, la loi de Moore se heurte également à une limite fondamentale : les transistors atteignent désormais une taille inférieure à 2 nanomètres, seuil où les effets quantiques rendent leur comportement instable. Fabriquer des transistors plus petits tutoie l’impossible, pour l’heure. C’est l’un des grands défis que doivent surmonter les ingénieurs d’Intel, TSMC, Samsung et leurs pairs.

Rappelons aussi que, pour l’heure, les intelligences artificielles ne produisent rien par elles-mêmes : il faut toujours un pilote dans l’avion, à un moment donné de la chaîne. Certes, elles seront sûrement capables, un jour, d’engendrer de nouvelles formes de production. Mais se posera alors une question essentielle : pourquoi le feraient-elles ?

Car si l’humain travaille, ce n’est pas uniquement pour gagner sa vie, mais pour améliorer sa condition et préserver un sens à son existence. Le travail n’est pas qu’une production : c’est un mouvement vital, une manière de se tenir en action. De ne pas être inerte. De créer de l’agitation. Et parce que ce mouvement est rémunéré, il engendre aussitôt un autre cycle : celui de la dépense, qui réactive à son tour la dynamique productive. Une boucle énergétique où l’humain trouve à la fois son utilité, son équilibre… et sa raison d’être.

Aussi, rappelons que le rêve d’AGI – l’intelligence artificielle générale – reste, pour l’instant, un idéal technophile plus qu’une réalité technique. Quand on songe qu’un enfant reconnaît un chat après l’avoir vu une seule fois, alors qu’une IA doit en digérer des millions, ça en dit long.

Nous surestimons souvent les capacités de la machine à savoir faire vite et bien. Et nous sous-estimons encore trop la puissance d’abstraction humaine.

Quoique, il y a peut-être un domaine dans lequel nous surestimons nos capacités : la gestion du risque financier.